Ada tiga juta aduan ujaran kebencian oleh pengguna Twitter selama 2018, sekitar 10 persen ditindaklanjuti. Image: Shutterstock

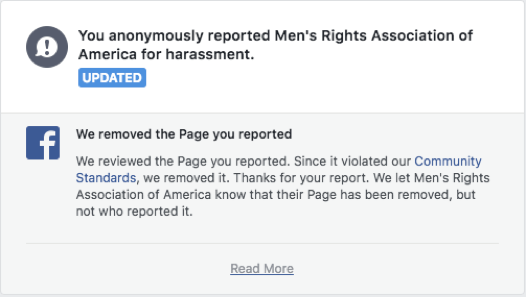

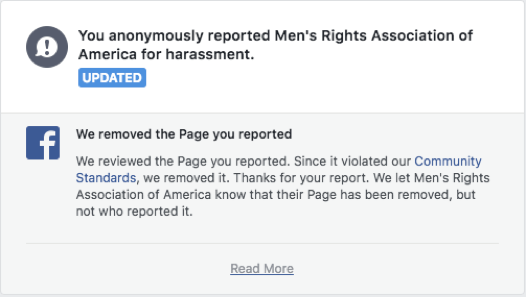

Setahun setelah viralnya gerakan #MeToo, berita buruk kerap bermunculan dan kaum adam masih belum “ngerti” seberapa serius isu kekerasan dan pelecehan perempuan. Saya sampai lelah menghadapi ini semua. Saya awalnya berasumsi orang udah bosan aja dengar berita yang itu-itu lagi. Sampai akhirnya salah satu teman memberi tahu kalau dia dengan balas dendam terhadap para lelaki brengsek di media sosial.Teman saya berhasil melaporkan konten sarat kebencian di internet, termasuk grup "hak asasi laki-laki misoginis" di Facebook. Tak sampai sehari dilaporkan, Facebook langsung menutup grupnya atau menghapus postingan spesifik di laman tersebut. Warganet semakin giat mendesak perusahaan media sosial untuk meningkatkan moderasinya, tapi ternyata mereka akan lebih tanggap meninjau suatu konten kalau kita yang melaporkannya langsung.“Akan lebih baik kalau kamu segera melaporkannya ketika menemukan konten negatif atau yang melanggar kebijakan platform,” kata Kat Lo, peneliti komunitas daring di University of California Irvine, lewat email. “Salah besar kalau kamu mengira perusahaan hanya membaca semua interaksi sosial pengguna dan membiarkannya saja. Kebanyakan dari mereka melakukannya berdasarkan laporan.”Namun, internet yang aman tentu masih jadi tanggung jawab platform media sosial. Mereka seharusnya benar-benar menegakkan persyaratan layanannya dan selalu meningkatkan metode moderasi kontennya. Facebook berusaha memastikan kalau miliaran penggunanya mematuhi standar komunitas mereka, termasuk bagian tentang ujaran kebencian yang secara khusus melarang “pendapat yang merendahkan”. Aturan dan kebijakan Twitter secara spesifik menjabarkan “kebijakan perilaku kebencian” yang tidak mengizinkan penggunanya untuk membuat postingan yang “memicu ketakutan”, “menggambarkan kebencian” dan konten berbahaya lainnya.Perusahaan-perusahaan medsos sebetulnya harus beroperasi sesuai aturan hukum yang berbeda di setiap negara, contohnya patuh pada Peraturan Perlindungan Data Umum Uni Eropa. Faktanya sebagian besar platform tidak mau diatur.Facebook, Twitter, dan platform utama lainnya menggunakan kombinasi moderator kecerdasan buatan dan manusia buat mengawasi konten. Hanya saja, Lo memperingatkan kalau algoritma sulit memahami konteks suatu postingan, yang secara bahasa tak terlihat menyinggung. “Konteks suatu postingan sangat menentukan bagaimana kamu menanggapi pernyataan individual. Tak ada cara yang tepat bagi kita untuk menentukan konteks dan motivasi seseorang menggunakan komputer,” katanya.Moderator manusia bisa saja kurang memahami konteks penuh suatu postingan karena mereka diminta untuk memoderasi postingan dalam jumlah banyak. Mereka terkadang juga harus memoderasi konten di negara atau yang menggunakan bahasa yang tidak familiar. Seorang moderator bahkan pernah menuntut Facebook karena pekerjaannya mengurusi konten “yang sangat tidak sehat” membuat dia mengalami PTSD.Pengguna juga bisa melaporkan kontennya. “Kita tidak berhubungan langsung di internet sehingga tak ada yang tahu siapa kita. Kita juga punya tingkat penghalang tertentu yang memungkinkan kita untuk berkomunikasi secara berbeda,” kata Priya Kumar, research fellow Social Media Lab di Universitas Ryerson, Toronto.Terkadang kurangnya pengendalian itu tidak bagus. “Ancaman, perilaku agresif atau ketidakstabilan pun bermunculan,” kata Kumar. Tapi tidak mesti begitu. Anonimitas penghalang bisa mempermudah kita untuk melaporkan konten berbahaya.Pengguna internet melaporkan sebanyak 2.698.613 akun untuk perilaku kebencian di Twitter dari Januari hingga Juni 2018. 285.393 darinya mengakibatkan Twitter mengambil langkah lebih lanjut terhadap mereka. Jumlahnya bahkan hanya 10 persen dari laporan. Facebook mengatakan bahwa mereka meninjau lebih dari 2 juta konten setiap harinya. Mereka bertujuan untuk merespons dalam 24 jam, tergantung pada seberapa jelas kasusnya.Juru bicara Facebook mengungkapkan kepada staf Motherboard lewat email kalau mereka sebenarnya menganggap laporan pengguna sebagai bagian penting moderasi. “Postingan seperti ‘gila lo’ bisa jadi bercandaan dan juga hinaan. Kami tidak mengetahui konteks luring itu, makanya laporan pengguna sangat penting,” kata mereka.Evan Balgord, direktur eksekutif Canadian Anti-Hate Network, menjelaskan bahwa laporan pengguna sangat membantu dalam menarik perhatian moderator terhadap frasa yang mungkin tidak diketahui moderator atau sistem AI, seperti ketika kelompok pembenci menggunakan bahasa berkode ( akademisi “dog whistling”) yang hanya diketahui grup tertentu. Misalnya, kelompok supremasi kulit putih menggunakan istilah “Day of the Rope” saat membahas ingin membunuh “pengkhianat ras.” Saya mencari istilah ancaman ini di Twitter, dan segera melihat aktivitas yang mencurigakan.

Warganet semakin giat mendesak perusahaan media sosial untuk meningkatkan moderasinya, tapi ternyata mereka akan lebih tanggap meninjau suatu konten kalau kita yang melaporkannya langsung.“Akan lebih baik kalau kamu segera melaporkannya ketika menemukan konten negatif atau yang melanggar kebijakan platform,” kata Kat Lo, peneliti komunitas daring di University of California Irvine, lewat email. “Salah besar kalau kamu mengira perusahaan hanya membaca semua interaksi sosial pengguna dan membiarkannya saja. Kebanyakan dari mereka melakukannya berdasarkan laporan.”Namun, internet yang aman tentu masih jadi tanggung jawab platform media sosial. Mereka seharusnya benar-benar menegakkan persyaratan layanannya dan selalu meningkatkan metode moderasi kontennya. Facebook berusaha memastikan kalau miliaran penggunanya mematuhi standar komunitas mereka, termasuk bagian tentang ujaran kebencian yang secara khusus melarang “pendapat yang merendahkan”. Aturan dan kebijakan Twitter secara spesifik menjabarkan “kebijakan perilaku kebencian” yang tidak mengizinkan penggunanya untuk membuat postingan yang “memicu ketakutan”, “menggambarkan kebencian” dan konten berbahaya lainnya.Perusahaan-perusahaan medsos sebetulnya harus beroperasi sesuai aturan hukum yang berbeda di setiap negara, contohnya patuh pada Peraturan Perlindungan Data Umum Uni Eropa. Faktanya sebagian besar platform tidak mau diatur.Facebook, Twitter, dan platform utama lainnya menggunakan kombinasi moderator kecerdasan buatan dan manusia buat mengawasi konten. Hanya saja, Lo memperingatkan kalau algoritma sulit memahami konteks suatu postingan, yang secara bahasa tak terlihat menyinggung. “Konteks suatu postingan sangat menentukan bagaimana kamu menanggapi pernyataan individual. Tak ada cara yang tepat bagi kita untuk menentukan konteks dan motivasi seseorang menggunakan komputer,” katanya.Moderator manusia bisa saja kurang memahami konteks penuh suatu postingan karena mereka diminta untuk memoderasi postingan dalam jumlah banyak. Mereka terkadang juga harus memoderasi konten di negara atau yang menggunakan bahasa yang tidak familiar. Seorang moderator bahkan pernah menuntut Facebook karena pekerjaannya mengurusi konten “yang sangat tidak sehat” membuat dia mengalami PTSD.Pengguna juga bisa melaporkan kontennya. “Kita tidak berhubungan langsung di internet sehingga tak ada yang tahu siapa kita. Kita juga punya tingkat penghalang tertentu yang memungkinkan kita untuk berkomunikasi secara berbeda,” kata Priya Kumar, research fellow Social Media Lab di Universitas Ryerson, Toronto.Terkadang kurangnya pengendalian itu tidak bagus. “Ancaman, perilaku agresif atau ketidakstabilan pun bermunculan,” kata Kumar. Tapi tidak mesti begitu. Anonimitas penghalang bisa mempermudah kita untuk melaporkan konten berbahaya.Pengguna internet melaporkan sebanyak 2.698.613 akun untuk perilaku kebencian di Twitter dari Januari hingga Juni 2018. 285.393 darinya mengakibatkan Twitter mengambil langkah lebih lanjut terhadap mereka. Jumlahnya bahkan hanya 10 persen dari laporan. Facebook mengatakan bahwa mereka meninjau lebih dari 2 juta konten setiap harinya. Mereka bertujuan untuk merespons dalam 24 jam, tergantung pada seberapa jelas kasusnya.Juru bicara Facebook mengungkapkan kepada staf Motherboard lewat email kalau mereka sebenarnya menganggap laporan pengguna sebagai bagian penting moderasi. “Postingan seperti ‘gila lo’ bisa jadi bercandaan dan juga hinaan. Kami tidak mengetahui konteks luring itu, makanya laporan pengguna sangat penting,” kata mereka.Evan Balgord, direktur eksekutif Canadian Anti-Hate Network, menjelaskan bahwa laporan pengguna sangat membantu dalam menarik perhatian moderator terhadap frasa yang mungkin tidak diketahui moderator atau sistem AI, seperti ketika kelompok pembenci menggunakan bahasa berkode ( akademisi “dog whistling”) yang hanya diketahui grup tertentu. Misalnya, kelompok supremasi kulit putih menggunakan istilah “Day of the Rope” saat membahas ingin membunuh “pengkhianat ras.” Saya mencari istilah ancaman ini di Twitter, dan segera melihat aktivitas yang mencurigakan.

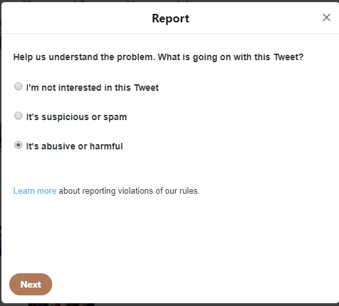

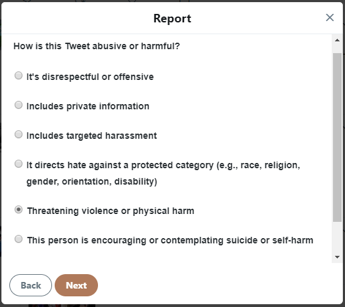

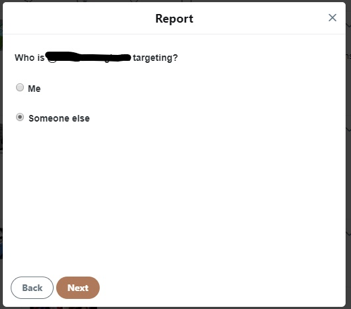

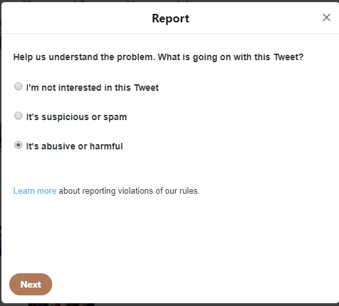

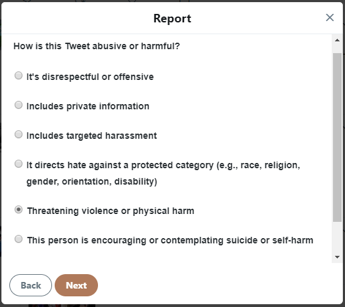

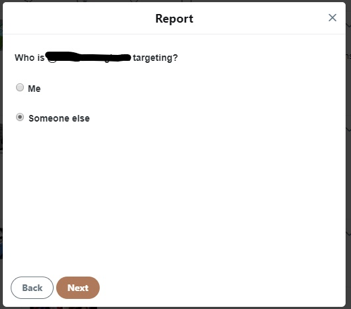

Setelah saya melaporkan twit Day of the Rope, Twitter mengizinkanku untuk menambahkan empat twit lainnya dari akun negatif tersebut. Apabila postingannya menyinggung tapi tidak berbahaya, seringkali kita sulit menemukan konten buruk yang lebih eksplisit. Kali ini, saya bisa menemukan lima.Pengguna yang melanggar kode etik Twitter baru bisa mengetwit lagi apabila mereka sudah menghapus twit yang ofensif itu. Twitter tidak langsung menghapusnya. Dalam postingan blog Oktober lalu, Twitter menjelaskan bahwa “Setelah kami meminta Twitnya untuk dihapus, kami akan menampilkan pemberitahuan bahwa Twitnya tidak tersedia karena telah melanggar Aturan Twitter.”Warman mengajukan 16 aduan HAM melawan grup kebencian berkat undang-undang tersebut. Semua kasusnya dimenangkan.Pada 2013, pemerintah konservatif minoritas Kanada mencabut seksi 13 dengan alasan seksi tersebut “melanggar kebebasan berbicara.” Kini, satu-satunya cara untuk menuntut ujaran kebencian adalah melalui kode kriminal. Kode tersebut melarang penghasutan genosida dan kebencian publik terhadap “grup-grup ilegal yang dapat diidentifikasi secara resmi.” Sayangnya, Warman berkata bahwa kini mengajukan pengaduan melalui kode kriminal jauh lebih susah akibat berbagai faktor—misalnya kekurangan divisi kepolisian yang menangani kejahatan kebencian.Sejak pencabutan seksi 13, kekurangan legislasi HAM telah membiarkan internet menjadi “got,” kata Warman. “Sekarang orang boleh mengatakan apa saja yang mereka inginkan dan mengeluarkan semua kebencian mereka dalam hal propaganda kebencian,” katanya.Di Amerika Serikat, menuntut ujaran kebencian nyaris mustahil. Mahkamah Agung AS menegaskan bahwa amandemen pertama konstitusi melindungi ujaran kebencian, terakhir kalinya dalam kasus Matal vs. Tam. Selain itu, undang-undang kejahatan kebencian berbeda di setiap negara bagian.Konsekuensi kebencian online sudah jelas—dari serangan mobil van di Toronto terkait 4chan, hingga propaganda di Facebook yang membantu menimbulkan genosida Rohingya, diskusi yang meliputi moderasi konten berfokus pada pencegahan ujaran kebencian terbuka, bukan melindungi kebebasan berbicara.Jadi bagaimana cara kita bisa melawan kekacauan ini? Kalau pelaporan tidak mengakibatkan platform menghapus konten berbahaya, Warman menegaskan bahwa pelaporan setidaknya akan menciptakan catatan historis yang dapat membantu mempertanggung jawabkan perusahaan jika terjadi hal yang lebih mengancam akibat postingan.“Selama sebagian besar masa hidup mereka, platform medsos telah mempertahankan metode moderasi konten yang tidak langsung—“tidak terlihat, maka tidak terpikirkan,” katanya. “Kita melihat pada 2018 ada dorongan untuk konsultasi antara ketua-ketua industri medsos, pemerintah, pembuat legislasi, dan peneliti internet.”Pada 2018, mantan menteri keadilan Jody Wilson-Raybould (yang kini menjabat sebagai menteri Urusan Veteran) mengisyaratkan bahwa pemerintah liberal Kanada akan mengembalikan seksi 13. Twitter mempromosikan “percakapan sehat”. Mark Zuckerberg berjanji Facebook akan lebih proaktif dalam mengidentifikasi konten bahaya dan bekerjasama dengan pemerintah dalam hal regulasi. Pada 2019, Facebook berkata akan menyediakan opsi naik banding bagi moderatornya yang percaya konten tertentu tidak melanggar kebijakan Facebook.Kamu tak perlu menjadi pejuang internet yang main hakim sendiri untuk berperan dalam penanganan konten berbahaya. Atau kalau kamu melihat orang yang kamu kenal membagikan propaganda kebencian, Warman menegaskan bahwa kamu selalu bisa mengambil jalur jadul membela orang lain. "Katakan saja kepada pengguna medsos macam itu, ‘jangan jadi orang berengsek kenapa sih?!"Artikel ini pertam kali tayang di Motherboard

Setelah saya melaporkan twit Day of the Rope, Twitter mengizinkanku untuk menambahkan empat twit lainnya dari akun negatif tersebut. Apabila postingannya menyinggung tapi tidak berbahaya, seringkali kita sulit menemukan konten buruk yang lebih eksplisit. Kali ini, saya bisa menemukan lima.Pengguna yang melanggar kode etik Twitter baru bisa mengetwit lagi apabila mereka sudah menghapus twit yang ofensif itu. Twitter tidak langsung menghapusnya. Dalam postingan blog Oktober lalu, Twitter menjelaskan bahwa “Setelah kami meminta Twitnya untuk dihapus, kami akan menampilkan pemberitahuan bahwa Twitnya tidak tersedia karena telah melanggar Aturan Twitter.”Warman mengajukan 16 aduan HAM melawan grup kebencian berkat undang-undang tersebut. Semua kasusnya dimenangkan.Pada 2013, pemerintah konservatif minoritas Kanada mencabut seksi 13 dengan alasan seksi tersebut “melanggar kebebasan berbicara.” Kini, satu-satunya cara untuk menuntut ujaran kebencian adalah melalui kode kriminal. Kode tersebut melarang penghasutan genosida dan kebencian publik terhadap “grup-grup ilegal yang dapat diidentifikasi secara resmi.” Sayangnya, Warman berkata bahwa kini mengajukan pengaduan melalui kode kriminal jauh lebih susah akibat berbagai faktor—misalnya kekurangan divisi kepolisian yang menangani kejahatan kebencian.Sejak pencabutan seksi 13, kekurangan legislasi HAM telah membiarkan internet menjadi “got,” kata Warman. “Sekarang orang boleh mengatakan apa saja yang mereka inginkan dan mengeluarkan semua kebencian mereka dalam hal propaganda kebencian,” katanya.Di Amerika Serikat, menuntut ujaran kebencian nyaris mustahil. Mahkamah Agung AS menegaskan bahwa amandemen pertama konstitusi melindungi ujaran kebencian, terakhir kalinya dalam kasus Matal vs. Tam. Selain itu, undang-undang kejahatan kebencian berbeda di setiap negara bagian.Konsekuensi kebencian online sudah jelas—dari serangan mobil van di Toronto terkait 4chan, hingga propaganda di Facebook yang membantu menimbulkan genosida Rohingya, diskusi yang meliputi moderasi konten berfokus pada pencegahan ujaran kebencian terbuka, bukan melindungi kebebasan berbicara.Jadi bagaimana cara kita bisa melawan kekacauan ini? Kalau pelaporan tidak mengakibatkan platform menghapus konten berbahaya, Warman menegaskan bahwa pelaporan setidaknya akan menciptakan catatan historis yang dapat membantu mempertanggung jawabkan perusahaan jika terjadi hal yang lebih mengancam akibat postingan.“Selama sebagian besar masa hidup mereka, platform medsos telah mempertahankan metode moderasi konten yang tidak langsung—“tidak terlihat, maka tidak terpikirkan,” katanya. “Kita melihat pada 2018 ada dorongan untuk konsultasi antara ketua-ketua industri medsos, pemerintah, pembuat legislasi, dan peneliti internet.”Pada 2018, mantan menteri keadilan Jody Wilson-Raybould (yang kini menjabat sebagai menteri Urusan Veteran) mengisyaratkan bahwa pemerintah liberal Kanada akan mengembalikan seksi 13. Twitter mempromosikan “percakapan sehat”. Mark Zuckerberg berjanji Facebook akan lebih proaktif dalam mengidentifikasi konten bahaya dan bekerjasama dengan pemerintah dalam hal regulasi. Pada 2019, Facebook berkata akan menyediakan opsi naik banding bagi moderatornya yang percaya konten tertentu tidak melanggar kebijakan Facebook.Kamu tak perlu menjadi pejuang internet yang main hakim sendiri untuk berperan dalam penanganan konten berbahaya. Atau kalau kamu melihat orang yang kamu kenal membagikan propaganda kebencian, Warman menegaskan bahwa kamu selalu bisa mengambil jalur jadul membela orang lain. "Katakan saja kepada pengguna medsos macam itu, ‘jangan jadi orang berengsek kenapa sih?!"Artikel ini pertam kali tayang di Motherboard

Iklan

Iklan

Iklan

Iklan

Saya melihat kalau akun Twitter yang saya laporkan masih ada saat saya mengeceknya dua minggu kemudian. Akan tetapi, twitnya sudah tidak ada. Ini memang cuma tindakan kecil, sih, tapi orang lain tidak perlu melihat konten kebencian itu kalau kita melaporkannya.Pengguna yang melaporkan konten melakukan tugas yang penting: “melindungi pengguna lain yang berpotensi terpapar bahaya,” kata Kumar.Sebenarnya membetulkan masalah medsos dengan konten sarat kebencian itu bukan tugas para pengguna, maka demi kewarasanmu, mencari konten macam itu secara aktif tidak dianjurkan.Lagipula, memoderasi medsos adalah pekerjaan penuh waktu. Karena konten sarat kebencian sangat meresap, angka pelaporan pengguna yang tinggi takkan mengalihkan tanggung jawab moderasi dari platform kepada penggunanya. Alih-alih, kata Lo, pelaporan tersebut membantu “perusahaan medsos mengidentifikasi di mana sistem mereka gagal” dalam pencarian grup sarat kebencian.Selain itu, medsos merupakan satu dari sedikit sarana yang tersedia untuk pelaporan, apalagi karena jalur pengadilan semakin sulit. Richard Warman, pengacara HAM asal Ottawa dan anggota dewan Anti-Kebencian Kanada, berperan dalam pelaporan konten yang melanggar hukum sejak awal. Sebelum 2013, seksi 13 dari undang-undang HAM Kanada melarang penggunaan telepon dan internet untuk menyebar propaganda kebencian terhadap individu atau grup.Katakan saja kepada pengguna medsos macam itu, ‘jangan jadi orang berengsek kenapa sih?!

Iklan

Iklan