Immagine: Shutterstock

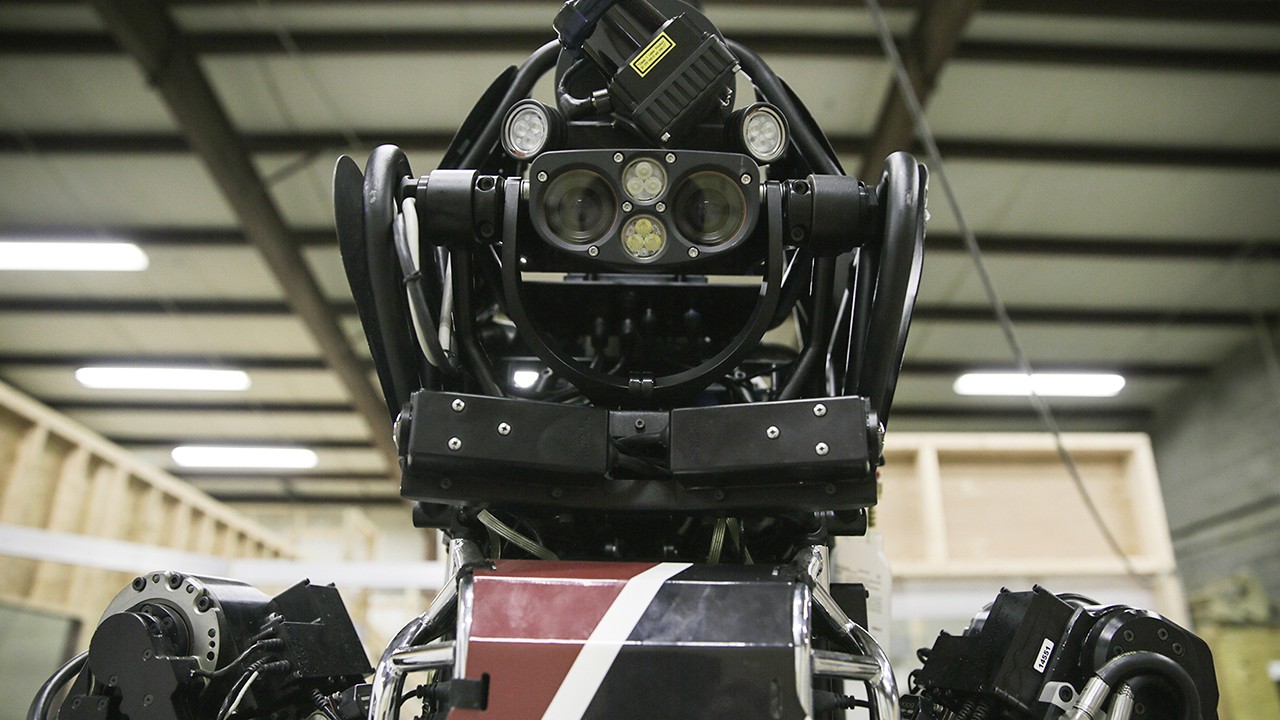

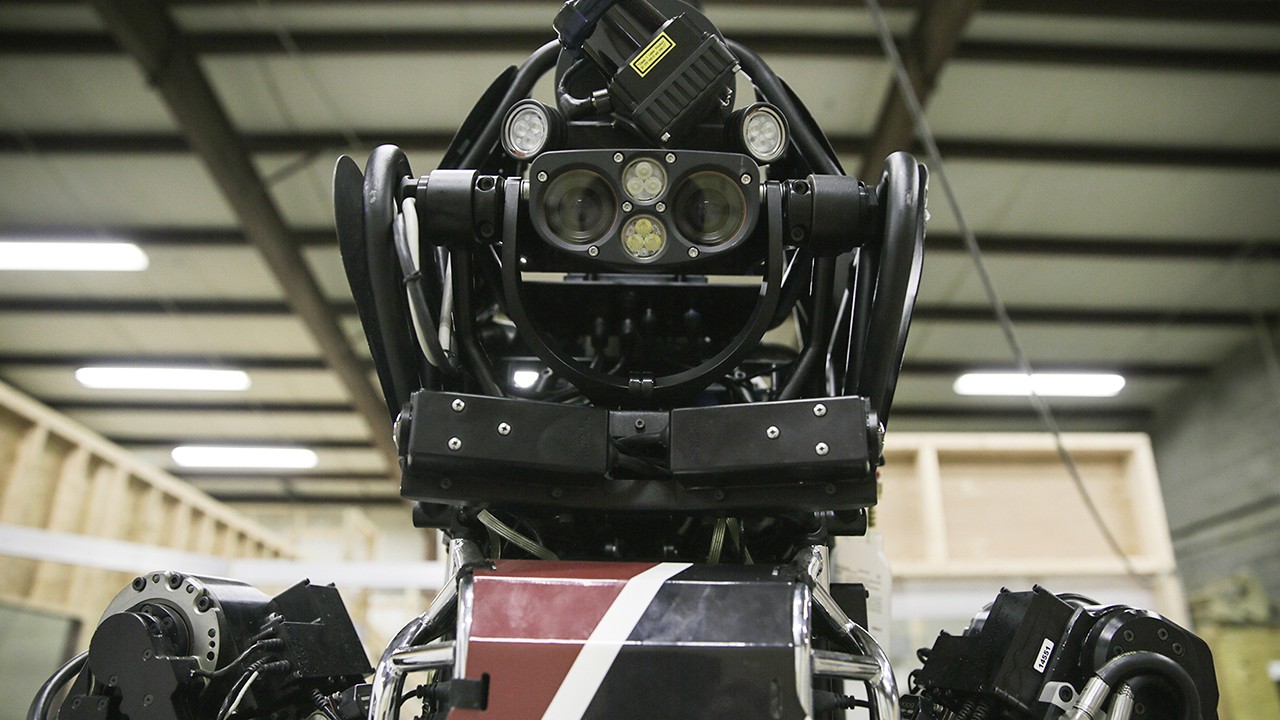

Quando pensiamo all'intelligenza artificiale, la prima cosa che ci viene in mente sono le rappresentazioni umanizzate di sistemi di machine learning come Siri o Alexa, ma, in verità, l'intelligenza artificiale è ovunque, per lo più come processo in background. Questa lenta colonizzazione dell'IA in settori che vanno dalla medicina alla finanza non è facile da percepire, anche solo perché ha un aspetto molto diverso dalla IA sognata da Hollywood in film come Deus Ex Machina o Her. Anzi, la IA di oggi è tutto sommato abbastanza stupida se paragonata all'uomo — un algoritmo di machine learning sarà anche più bravo di noi in un compito specifico, tipo giocare a Go, ma fatica ancora a compiere azioni più mondane, tipo distinguere una tartaruga da una pistola.Ciononostante, un gruppo di 26 ricercatori in IA si è incontrato a Oxford a febbraio scorso per discutere di come l'intelligenza artificiale super-umana possa essere impiegata a fin di male in futuro. Il risultato di questa conferenza di due giorni è un documento da 100 pagine pubblicato oggi, che esplora quali rischi corriamo se la IA finisse nelle mani sbagliate, e quali strategie adottare per mitigarli.Una delle quattro raccomandazioni fondamentali fatte dal gruppo è che "i ricercatori e gli ingegneri che si occupano di IA dovrebbero prendere seriamente la natura duale del proprio lavoro, considerando anche eventuali abusi mentre stabiliscono norme e priorità della ricerca e contattando attivamente gli enti rilevanti in caso prevedano applicazioni dannose."Per quanto i deepfake appaiano nel documento, i ricercatori hanno anche sottolineato come l'uso di tecniche simili per manipolare i video di leader mondiali costituisca una minaccia alla sicurezza politica, uno dei tre ambiti considerati a rischio a loro avviso. Basta immaginare un video fake di Trump che dichiara guerra alla Corea del Nord che comincia a girare a Pyongyang e le plausibili conseguenze, per capire cosa c'è in gioco. Inoltre, i ricercatori hanno individuato l'uso della IA nella sorveglianza di massa attraverso analisi dati e manipolazione attraverso la propaganda mirata come un'altra area di preoccupazione politica.Le altre due aree considerate a maggior rischio sono la sicurezza digitale e quella fisica. In termini di sicurezza digitale, l'uso della IA per compiere cyber-attacchi "ridurrà il compresso attuale tra la scala e l'efficienza degli attacchi." In altre parole la IA potrebbe compiere attacchi informatici che richiedono tempo e fatica come il phishing su larga scala, o forme più sofisticate come usare sintetizzatori vocali per impersonare una vittima.In termini invece di minacce fisiche, i ricercatori hanno esaminato il crescente affidamento che fa il mondo fisico sui sistemi automatizzati. Più case "intelligenti" e auto senza pilota vanno online, più la IA potrebbe essere usata per sovvertire questi sistemi e causare danni catastrofici. Poi ci sono i sistemi IA fatti apposta per essere dannosi, come le armi autonome o gli sciami di micro-droni.Alcuni di questi scenari, tipo una piaga egizia di micro-droni, sembrano ancora irrealistici, ma altri, come gli attacchi informatici su larga scala e le armi autonome e la manipolazione video stanno già creando problemi. per poter contrastare queste minacce, e assicurarsi che la IA sia usata per il bene dell'umanità, i ricercatori raccomandano lo sviluppo di nuove soluzioni normative e l'esplorazione di diversi "modelli di apertura" per mitigare i rischi della IA. Per esempio, i ricercatori suggeriscono l'adozione di modelli di licenza ad accesso centrale per evitare che le tecnologie di IA non cadano nelle mani sbagliate, o l'istituzione di una sorta di programma di monitoraggio per tenere traccia dell'uso delle risorse di IA. "La tendenza di oggi è diffondere in open access le ricerche d'avanguardia e i traguardi raggiunti nei progetti di sviluppo," scrivono gli autori del documento. "Se continua così per altri cinque anni, possiamo aspettarci un aumento radicale delle capacità degli hacker di provocare danni tramite sistemi digitali e robotici."D'altro canto, i ricercatori riconoscono che la proliferazione delle tecnologie di IA open-source attirerà nel tempo anche l'attenzione di legislatori e politici, che imporranno nuove limitazioni. Per quanto riguarda la forma che dovrebbero prendere queste nuove norme, sarà responsabilità di amministrazioni tanto locali che nazionali che internazionali."Restano molti punti di disaccordo tra i co-autori di questo documento, senza contare le varie comunità di esperti nel mondo," conclude il testo. "Molte di questi punti non saranno risolti finché non avremo più dati a disposizione, man mano che si presenteranno le varie minacce e le conseguenti soluzioni, ma questa incertezza e questo dissenso tra esperti non deve paralizzarci dall'adottare misure precauzionali già oggi."Questo articolo è apparso originariamente su Motherboard US.

"La tendenza di oggi è diffondere in open access le ricerche d'avanguardia e i traguardi raggiunti nei progetti di sviluppo," scrivono gli autori del documento. "Se continua così per altri cinque anni, possiamo aspettarci un aumento radicale delle capacità degli hacker di provocare danni tramite sistemi digitali e robotici."D'altro canto, i ricercatori riconoscono che la proliferazione delle tecnologie di IA open-source attirerà nel tempo anche l'attenzione di legislatori e politici, che imporranno nuove limitazioni. Per quanto riguarda la forma che dovrebbero prendere queste nuove norme, sarà responsabilità di amministrazioni tanto locali che nazionali che internazionali."Restano molti punti di disaccordo tra i co-autori di questo documento, senza contare le varie comunità di esperti nel mondo," conclude il testo. "Molte di questi punti non saranno risolti finché non avremo più dati a disposizione, man mano che si presenteranno le varie minacce e le conseguenti soluzioni, ma questa incertezza e questo dissenso tra esperti non deve paralizzarci dall'adottare misure precauzionali già oggi."Questo articolo è apparso originariamente su Motherboard US.

Pubblicità

Questa raccomandazione è particolarmente rilevante alla luce del recente caso del "deepfake," un metodo di machine learning usato soprattutto per applicare i volti delle star di Hollywood ai corpi di attrici porno. Come riportato in precedenza da Motherboard, alla base di questi deepfake c'è una library di machine learning open source chiamata TensorFlow, sviluppata in principio dagli ingegneri di Google. I deepfake sono l'esempio perfetto della natura duale degli strumenti di machine learning e ci spingono a chiederci chi dovrebbe avere accesso a questa tecnologia.LEGGI DI PIÙ:

Leggi artificiali per intelligenze artificiali

Questa intelligenza artificiale riesce ad aggirare i CAPTCHA

Nella Silicon Valley il culto delle macchine è una vera e propria religione

Pubblicità

Pubblicità